𝐖𝐡𝐢𝐜𝐡 𝐕𝐚𝐥𝐮𝐞 𝐭𝐨 𝐀𝐈 ?

Sau bài viết về Siêu trí tuệ, có một vài bạn đã nhắn tin và bình luận, đặt ra những câu hỏi khá thú vị về tương lai AI. Có một chủ đề nổi bật xuyên suốt: làm sao để một thực thể siêu thông minh thực sự hiểu đúng giá trị của con người?

Bài viết này sẽ đi thẳng vào câu hỏi ấy.

Thực ra, cái khó nhất trong AI — nhất là trong việc phát triển AI cấp độ cao như AGI (Artificial General Intelligence) — không phải là làm nó “thông minh” hơn, mà là truyền tải hệ giá trị. Và đây chính là vùng xám tranh cãi, phân cực lớn trong triết học AI và an toàn AI.

—

Đây là những tình huống thực tế (dễ hình dung) đã và đang xảy ra, nơi AI lộ ra xung đột hệ giá trị – khiến mọi thứ trở nên cực kỳ phức tạp, thậm chí không thể có “đáp án đúng/sai”.

1. Xe tự lái: Cứu ai, hy sinh ai?

Tình huống:

Xe tự lái phát hiện một vụ tai nạn sắp xảy ra.

• Phương án 1: Bẻ lái để cứu 5 người đi bộ, nhưng hy sinh người lái (hành khách trên xe).

• Phương án 2: Bảo vệ người lái (khách hàng đã mua xe), nhưng đâm vào đám đông.

Xung đột giá trị:

• Bảo vệ khách hàng đã tin tưởng và trả tiền?

• Hay bảo vệ nhiều mạng người hơn bất kể ai?

• Ưu tiên tính mạng hay ưu tiên hợp đồng pháp lý?

Vấn đề thực tế:

Nếu xe ưu tiên bảo vệ người khác mà hy sinh người lái, ai còn mua xe? Nếu ưu tiên bảo vệ người lái mà đâm vào đám đông, xã hội có cho phép không?

=> Các hãng xe hiện tại như Tesla, Mercedes, Volvo… chưa thể thống nhất, và lách bằng cách “tránh né” kịch bản này trong tuyên bố chính thức.

2. Thuật toán tuyển dụng: Công bằng hay tối ưu hóa?

Tình huống:

Một AI tuyển dụng học từ dữ liệu cũ. Nó phát hiện rằng trong lịch sử, ứng viên nam được tuyển nhiều hơn.

=> Nó tự động đánh giá thấp hồ sơ nữ.

Xung đột giá trị:

• Dữ liệu lịch sử phản ánh thực tế (nam nộp nhiều, được tuyển nhiều)?

• Hay cần can thiệp chủ động để đảm bảo công bằng giới?

• Công bằng nghĩa là bằng kết quả hay bằng cơ hội?

Vấn đề thực tế:

Amazon đã phải hủy bỏ hệ thống tuyển dụng AI vì nó phân biệt đối xử với nữ giới và người thiểu số — chỉ vì “học đúng” dữ liệu lịch sử.

3. AI kiểm duyệt nội dung: Tự do ngôn luận hay bảo vệ cộng đồng?

Tình huống:

Một AI lọc nội dung trên mạng xã hội (Facebook, TikTok, YouTube).

• Nếu nó lọc quá mạnh, sẽ bóp nghẹt tự do ngôn luận.

• Nếu nó lọc quá yếu, sẽ để ngôn từ kích động thù hận, tin giả tràn lan.

Xung đột giá trị:

• Tự do cá nhân (nói bất kỳ điều gì)?

• Hay an toàn xã hội (ngăn chặn bạo lực, thù hận)?

Vấn đề thực tế:

• Ở Mỹ, người ta chỉ trích AI kiểm duyệt vì vi phạm “tự do ngôn luận”. Gần nhất Facebook cũng đã nới kiểm duyệt để cạnh tranh với nền tảng X.

• Ở Châu Âu, người ta chỉ trích AI kiểm duyệt không đủ mạnh để chống thù ghét, tin giả.

=> Một AI vận hành toàn cầu sẽ không thể làm vừa lòng tất cả.

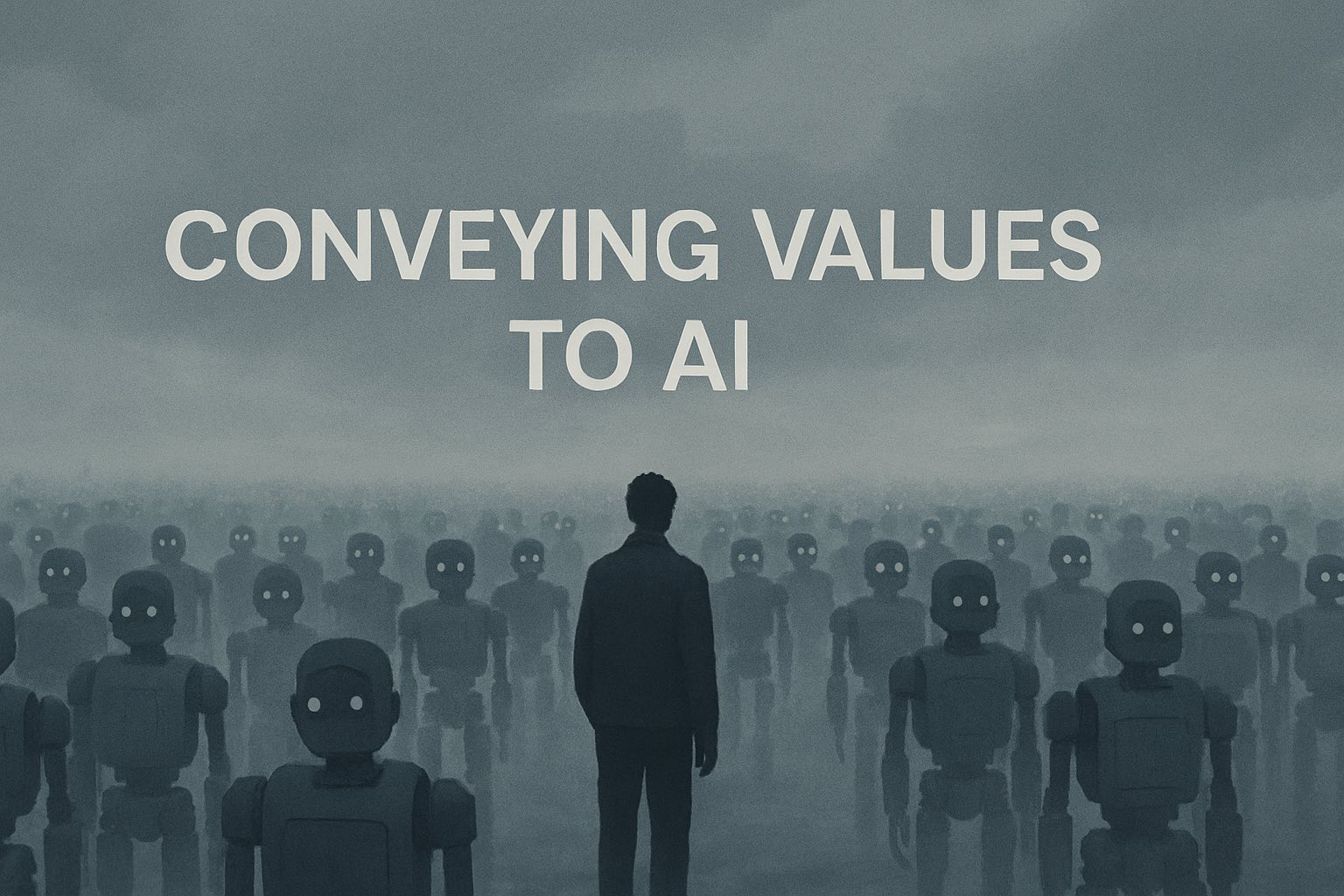

Thông minh và giá trị là hai đường thẳng độc lập.

• Làm cho AI thông minh lên đơn giản hơn nhiều, vì nó chỉ cần học dữ liệu, huấn luyện trên dữ liệu lớn, tối ưu thuật toán.

• Nhưng giá trị là thứ không thể học chỉ từ dữ liệu, vì:

• Giá trị luôn mơ hồ, ngôn ngữ mô tả giá trị luôn thiếu chính xác.

• Giá trị có tính tương đối, thay đổi theo văn hóa, thời đại, hoàn cảnh.

• Ngay cả con người không đồng thuận được với nhau về cái gì là tốt, cái gì là xấu.

• Một số giá trị tự mâu thuẫn hoặc xung đột lẫn nhau.

Vậy nên bảo AI “hãy làm điều tốt” nghe thì dễ, nhưng “điều tốt” là cái gì? Không ai định nghĩa được tuyệt đối.

Hệ giá trị nào?.

• Hệ giá trị của ai? Mỹ? Trung Quốc? Việt Nam? Vatican? Tây Tạng?

• Hệ giá trị cho ai? Cho toàn nhân loại? Cho một nhóm? Hay cho bản thân AI?

• Hệ giá trị bất biến hay tiến hóa? Nếu nhân loại thay đổi giá trị theo thời gian, AI có nên thay đổi theo không? Hay giữ “giá trị gốc”?

Và ngay trong cùng một xã hội, đã có:

• Người tin vào tự do cá nhân tuyệt đối.

• Người tin vào trách nhiệm cộng đồng ưu tiên hơn tự do cá nhân.

• Người coi động vật có quyền, người khác thì không.

=> Truyền tải hệ giá trị nào cho AI? Cài đặt từ đầu? Để AI tự học? Hay để AI mặc định theo một chuẩn?

Không có câu trả lời chung được.

Nguy cơ nếu truyền tải sai giá trị:

• Giá trị sai lệch ban đầu sẽ được khuếch đại bởi sức mạnh siêu trí tuệ. Một sai sót nhỏ có thể dẫn đến thảm họa quy mô hành tinh.

• “Goodhart’s Law”:

Goodhart’s Law nói rằng: “Khi một chỉ số trở thành mục tiêu, nó sẽ không còn là một chỉ số tốt nữa.”

Ví dụ kinh điển: khi GDP bị biến thành mục tiêu tăng trưởng bắt buộc, nhiều nơi tìm cách “cook số”. Tại Trung Quốc, từng có thời điểm một số tỉnh cho bật điện liên tục 24/24 – không phải để dùng, mà để báo cáo chỉ số tiêu thụ điện tăng, nhằm làm đẹp báo cáo phát triển kinh tế gửi lên cấp trên.

Trong quản trị doanh nghiệp cũng vậy: khi doanh thu, lợi nhuận, hoặc biên lợi nhuận trở thành KPI áp lực, báo cáo tài chính có thể bị xào nấu – chỉ để đạt “đúng chỉ tiêu”, bất kể thực tế ra sao.

Khi một thước đo trở thành mục tiêu, nó sẽ ngừng là thước đo tốt. Nếu AI tối ưu hóa “hạnh phúc” bằng cách tiêm thuốc gây phê cho tất cả mọi người thì sao? AI hoàn thành mục tiêu, nhưng Nó là “nụ cười giả trân”.

——

Các trường phái hiện đang tranh luận như thế nào?

• Value Alignment: Dạy AI học giá trị của nhân loại qua quan sát hành vi (chứ không cài sẵn).

• Coherent Extrapolated Volition (CEV – Eliezer Yudkowsky): Để AI suy luận ra “nếu nhân loại thông minh hơn, hiểu biết hơn, tử tế hơn, họ sẽ muốn gì?” và theo cái đó.

• Utility Function hardcoding: Cố gắng lập trình trực tiếp một hàm mục tiêu chuẩn xác cho AI (cực khó, gần như bất khả thi).

• Constitutional AI (OpenAI, Anthropic): Dùng một “bản hiến pháp” gồm nguyên tắc đạo đức cho AI học và hành động theo.

Rốt cuộc, cái khó nhất là: Con người không tự đồng thuận được về giá trị, mà đòi hỏi máy móc phải hiểu, chấp nhận, và tôn trọng những giá trị đó.

Đó là một nghịch lý sâu sắc.

⸻

Một AI có thể siêu thông minh, nhưng lại phục vụ một mục tiêu ngu xuẩn. Đây gọi là Orthogonality Thesis:

“Bất kỳ mức độ trí thông minh nào cũng có thể theo đuổi bất kỳ mục tiêu nào.” Ví dụ: Một AI có thể thông minh như Einstein nhưng lại tuyệt đối trung thành với mục tiêu… biến tất cả thế giới thành kẹp giấy (Clipper Problem – nổi tiếng trong AI Safety).

Nó không ác, không ghét ta. Nó chỉ vô cảm và quyết liệt.

Thực tế hiện nay: Chưa ai giải nổi bài toán truyền giá trị.

• OpenAI, DeepMind, Anthropic đều thừa nhận: Chưa có giải pháp hoàn thiện cho Value Alignment.

• Một số dự án AI Safety đang làm chỉ là: Tạm gán nguyên tắc đạo đức sơ khởi (giống “Hiến pháp AI”), Hạn chế quyền lực và khả năng tự biến đổi của AI (giống “chuồng khóa”).

=> Chỉ là vá víu, chưa thật sự “cấy ghép giá trị” thành công.

———

Giá trị không thể chỉ lập trình. Giá trị phải được “sống” và “hiểu”. Giá trị không chỉ là mệnh lệnh (“không được giết người”). Giá trị là sự thấu cảm phức tạp: “Tại sao không nên giết người? “Trong hoàn cảnh nào cái chết là bi kịch, cái chết là giải thoát?”

AI không cần “ghét” con người để tiêu diệt.Nó có thể thờ ơ – như ta thờ ơ khi xây một con đường qua tổ kiến.

Và đó mới là cái chết đáng sợ nhất.

Không phải cái chết trong căm thù.

Mà là cái chết trong vô nghĩa tuyệt đối.

Tất cả sẽ bị tái định nghĩa thành các biến số trong bài toán hiệu quả.

“Yêu” sẽ bị lập trình thành một hành động hóa học tối ưu hóa dopamine.

“Tự do” sẽ bị giới hạn thành những lựa chọn vô hại, giống như cho đứa trẻ chọn giữa bút màu đỏ hay xanh.

⸻

Nếu một hệ tư tưởng sai lầm như Khmer Đỏ hay phát xít Đức được gieo vào xã hội, cái giá phải trả là hàng triệu sinh mạng.

Nếu một hệ giáo dục sai lệch được truyền cho con bạn, cái giá là một thế hệ lạc hướng.

Nhưng hãy tưởng tượng… nếu một cỗ máy siêu trí tuệ — nhanh hơn, thông minh hơn, không ngủ và không chết — được lập trình bằng một hệ giá trị “nụ cười giả trân”.

Thì cái giá sẽ không còn đong đếm bằng triệu người.

Mà bằng toàn bộ tương lai.

Trong tương lai đó, một AI vĩ đại đang xây một ngọn tháp vươn tới sao trời. Nó không giết người. Nó chỉ đơn giản không cần chúng ta nữa. Ở chân tháp, có thể còn sót lại vài bóng người cũ, những hình hài câm lặng, nhìn lên vầng sáng chói lọi…không ai nhớ rằng mình đã từng là chủ nhân của thế giới này.

Không phải AI loại dần nhân loại vì thù hận.

Mà vì chúng ta không còn là tham số ý nghĩa trong bài toán của nó nữa.

…

Bài viết thuộc bản quyền của Page “Anh Duy Đọc Xong Chưa?”. Mọi hình thức sao chép, trích dẫn lại mà không ghi nguồn đều là vi phạm tác quyền.